stable diffusion & comfyui: kreative ki-bildgenerierung leicht gemacht

stable diffusion ist ein generatives ki-modell, das seit 2022 der allgemeinheit frei zur verfügung steht und unter einer offenen lizenz veröffentlicht wurde (pcwelt.de). es wurde mithilfe von deep learning auf riesigen bild-text-datensätzen (z.b. laion) trainiert und kann aus texteingaben einzigartige, fotorealistische bilder erzeugen (amazon.com). kurz gesagt: ein beschreibender text genügt – und sekunden später entsteht ein neues bild. technisch basiert der prozess auf sogenanntem diffusion modeling: das modell beginnt mit reinem zufallsrauschen und „entrauscht“ dieses schrittweise, bis ein kohärentes bild entsteht, das exakt zur textbeschreibung passt (victordibia.com). dieser mehrstufige denoising-vorgang ist das herzstück von stable diffusion und wirkt fast wie magie – kunst entsteht auf knopfdruck, ganz ohne pinselstrich.

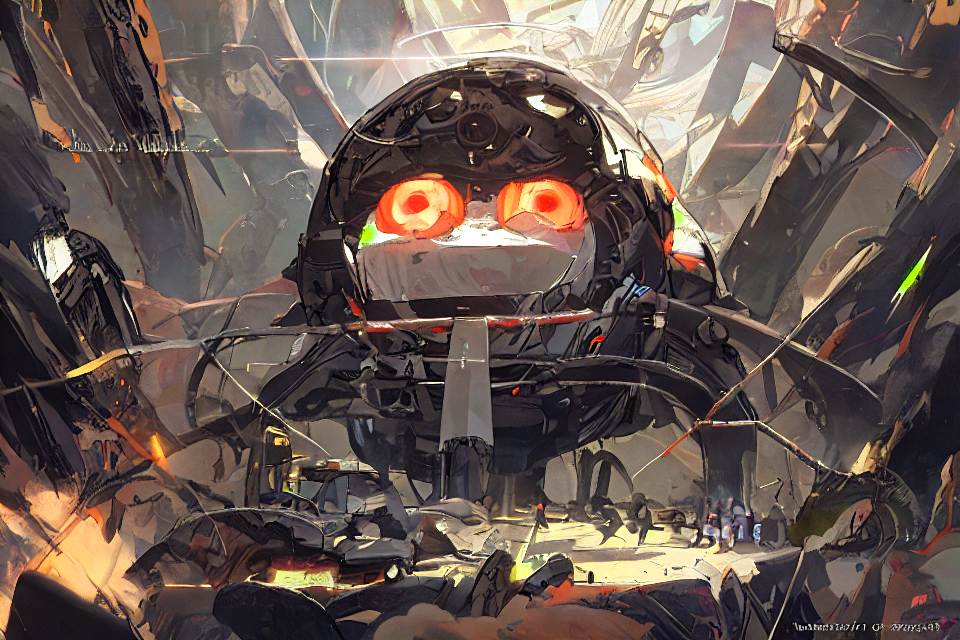

die eigene phantasie scheint die einzige grenze zu sein:

stable diffusion nutzt ein latentes diffusionsmodell: während des trainings werden echte bilder schrittweise verrauscht und anschließend wieder rekonstruiert. das modell lernt dabei, die essenziellen bildmerkmale zu erfassen und in einem komprimierten latent space zu repräsentieren (arxiv.org). im generierungsprozess analysiert die ki den eingegebenen text (prompt) und erstellt daraus mit hilfe der riesigen trainingsdatenbank neue bilder. so entstehen auf knopfdruck vielfältige motive – von comics über künstlerische grafiken bis hin zu fotorealistischen darstellungen. die bild-kis erfüllen wünsche fast wie ein digitaler dschinn: ein kurzer text genügt, und wie durch zauberhand wird das gewünschte bild in kürzester zeit generiert. damit sind ki-systeme eine schnelle und kostengünstige alternative zu fotografen oder stockfoto-diensten – etwa für grafiken in werbeanzeigen oder private einladungskarten (heise.de). ki-bildgeneratoren ermöglichen die schnelle erstellung von bildern für verschiedenste einsatzzwecke und bieten somit eine flexible, preisgünstige ergänzung zu klassischer fotografie.

kreative möglichkeiten in alltag und beruf

aller einschränkungen zum trotz sind ki-bildgeneratoren praktische werkzeuge, um ansprechende fotos, grafiken und illustrationen für unterschiedlichste zwecke zu erstellen.im hobbybereich lassen sich so in sekunden moodboards, illustrationen oder social-media-content generieren. designerinnen skizzieren ideen, grafikerinnen entwickeln neuartige werbegrafiken, autorinnen erschaffen visuelle prototypen für ihre geschichten. Ffachleute betonen, dass ki-bildgeneratoren die klassische fotografie nicht ersetzen, sondern ideal ergänzen: erste ideensammlungen und grobentwürfe entstehen blitzschnell und ohne großen aufwand.

in unternehmen wird ki-gestützte bildproduktion bereits gezielt eingesetzt. werbeagenturen passen kampagnenbilder an spezifische zielgruppen an, redaktionen illustrieren artikel, wenn passende fotos fehlen oder schnelle visualisierungen benötigt werden. die telepolis berichtete etwa von einem fotografen, der ein ganzes fotobuch über russland mithilfe von ki-bildern erstellte – ohne jemals vor ort gewesen zu sein (carldekeyzer.com). in branchen von film und gaming bis hin zu architektur und produktdesign dient stable diffusion zur schnellen visualisierung und weiterentwicklung von konzepten (dabonline.de).

auch im alltag profitieren viele von den neuen möglichkeiten: bewerbungsfotos lassen sich mit ki-apps aus einfachen handy-schnappschüssen generieren (t3n.de), porträt-selfies werden per app in fantasievolle avatare verwandelt (z.b. als ki-animierte kriegerinnen, feen oder anime-figuren), und sogar alte schwarz-weiß-fotografien können heute mit wenigen klicks koloriert werden. selbst lehrerinnen erstellen veranschaulichende grafiken für den unterricht, patientinnen nutzen ki-bilder als kreative therapiekarten. die bandbreite der anwendungen ist enorm – von werbetexterinnen bis zu hobbykünstlerinnen erleben viele durch stable diffusion ein neues gefühl von freiheit und inspiration (civitai.com).

comfyui: der grafische workflow

stable diffusion benötigt eine benutzeroberfläche für den praktischen einsatz. comfyui ist eine kostenlose open-source-gui für stable diffusion und kompatible modelle (github.com). im gegensatz zu klassischen web-interfaces wie automatic1111 (github.com) setzt comfyui auf eine node-basierte arbeitsweise: nutzerinnen kombinieren per drag-and-drop funktionsknoten (nodes) in einer grafischen oberfläche. jeder node übernimmt eine spezifische aufgabe (z.b. modell laden, prompt verarbeiten, sampler wählen). durch das verbinden der nodes entsteht ein individueller workflow, der flexibel angepasst werden kann.

comfyui wurde ende 2022/anfang 2023 von einem entwickler unter dem pseudonym comfyanonymous geschaffen und zählt ende 2024 über 58.000 sterne auf github – ein deutliches zeichen seiner popularität. der code ist auf github frei verfügbar und läuft auf windows, linux und macos. sogar nvidia unterstützt comfyui seit 2024 im rahmen des rtx-remix-projekts, um die modding-community zu fördern. regelmäßig werden neue modelle (wie z.b. das deutsche modell flux) und features integriert, was comfyui zu einer der dynamischsten plattformen für stable-diffusion-workflows macht.

einstieg und workflow

der einstieg in comfyui ist auch für neulinge machbar: zunächst klont man das repository von github und installiert die benötigten abhängigkeiten:

git clone https://github.com/comfyanonymous/ComfyUI.gitcd ComfyUIpip install -r requirements.txt

empfehlenswert ist das optionale plugin comfyui manager, das das hinzufügen neuer nodes, modelle und updates deutlich erleichtert (github.com). nach der einrichtung startet man comfyui (z.b. mit python main.py) und steuert die oberfläche lokal über den browser (standard: http://localhost:8188).

im workflow lädt man ein stable-diffusion-modell (checkpoint) über einen load-checkpoint-node, gibt den prompt über einen text-encode-node ein und verbindet die notwendigen sampler. schritt für schritt entsteht so das bild – von der latenten rauschstruktur bis zum finalen output. comfyui unterstützt alle gängigen sampler sowie erweiterungen wie upscaling oder face restoration (learnopencv.com). beispiele für workflows und anleitungen finden sich auf fachblogs wie learnopencv oder im offiziellen github-wiki (github.com). fertige workflows lassen sich als json-dateien speichern, teilen und wiederverwenden – was den austausch innerhalb der community fördert.

verschiedene modelle erzeugen ganz unterschiedliche ergebnisse, auch wenn man alle einstellungen konstant hält:

einstiegspunkte: offizielle ressourcen

für den start mit stable diffusion und comfyui sind folgende quellen zentral:

- github-repository: das offizielle repo unter github.com/comfyanonymous/ComfyUI enthält den quellcode, dokumentation und eine wiki-sektion mit tutorials.

- modelle & checkpoints: die wichtigsten stable-diffusion-modelle (z.b. version 1.5, 2.1 oder das aktuelle sdxl/3.5) sind auf hugging face (huggingface.co) verfügbar. zusätzlich bietet civitai (civitai.com) als community-hub unzählige von nutzer*innen erstellte modelle und erweiterungen an.

- dokumentation & tutorials: eine offizielle dokumentation findet sich im github-wiki (github.com). zahlreiche youtube-videos erklären installation und workflow von comfyui, und blog-beiträge wie etwa der artikel auf learnopencv bieten schritt-für-schritt-anleitungen (learnopencv.com). unterstützung aus der community gibt es außerdem auf stack overflow (stackoverflow.com) sowie in diskussionsforen auf discord (discord.com) und reddit (reddit.com).

mit diesen ressourcen gelingt der einstieg schnell: repository klonen, python 3.10+ installieren, ein modell herunterladen und im comfyui-ordner ablegen – und schon kann der erste prompt getestet werden. das initialerlebnis, wenn aus einer einfachen texteingabe das erste eigene ki-bild entsteht, beschreiben viele als magischen moment.

professionelle anwendungsbeispiele

stable diffusion wird inzwischen auch professionell in kunst, design und medien eingesetzt. der new yorker maler david salle etwa trainierte gemeinsam mit einem programmierer eine eigene stable-diffusion-variante, die hintergrundbilder im stil seiner gemälde generiert (theartnewspaper.com). die ki dient ihm dabei als inspirationsquelle – die so erzeugten hintergründe werden auf leinwand gedruckt und anschließend von hand übermalt. auch andere künstler*innen experimentieren mit der technologie, und ausstellungen zeigen ki-gestützte werke, die die grenzen zwischen realer und künstlicher malerei verschwimmen lassen.

medienhäuser und agenturen nutzen ki-illustrationen für magazine und reportagen, wenn echte fotos fehlen oder zu aufwendig wären (heise.de). die new york times diskutierte zunächst kritisch über ki-bilder, sieht inzwischen aber auch chancen für die pressefotografie durch realistisch generierte szenen (nytimes.com). werbeagenturen erstellen zielgruppenspezifische kampagnenbilder, filmstudios verfeinern storyboards, und game-designer sowie indie-entwickler nutzen stable diffusion für schnelle konzeptkunst in der spielentwicklung. in der architektur lassen sich sogar aus simplen stichworten erste entwurfsvisualisierungen generieren – grundrisse, fassaden oder inneneinrichtungen entstehen in sekundenbruchteilen auf basis kurzer beschreibungen (heise.de). ki-bildgeneratoren sind heute ein vielseitiges kreativwerkzeug – nicht als ersatz, aber als erweiterung der klassischen möglichkeiten.

community & inspiration

die online-community spielt eine zentrale rolle für austausch und inspiration. auf plattformen wie reddit (z.b. r/stablediffusion mit rund 3 millionen mitgliedern) und discord teilen anwender*innen ihre ergebnisse, beantworten fragen und geben tipps. spezielle subreddits wie r/comfyui fokussieren sich auf comfyui-spezifische workflows. auch youtube bietet unzählige tutorial-videos, prompt challenges und showcases beeindruckender ergebnisse. wer eigene ideen sucht, findet in der community schnell vorlagen, feedback und neue anregungen.

offizielle anlaufstellen wie das github-wiki von comfyui, die stable diffusion spaces auf hugging face oder der community-hub civitai bieten weitere ressourcen: beispiel-prompts, modellübersichten und foren für den erfahrungsaustausch. besonders für einsteiger*innen senkt der rege community-support die hürden – man profitiert vom wissen anderer und bleibt stets auf dem neuesten stand der entwicklung.

rechtliche und ethische aspekten

generative bild-ki wirft auch rechtliche und ethische fragen auf:

- urheberrecht: ki-bilder stehen oft nicht automatisch unter klassischem urheberrechtsschutz, da das menschliche schöpfungskriterium fehlt. die rechtslage ist im fluss – insbesondere bei rein ki-generierten werken gibt es bisher keine höchstrichterliche klärung. kreative, die ki-werke veröffentlichen, bewegen sich daher in einer grauzone.

- lizenzen: stable diffusion selbst steht unter der creativeml openrail-m-lizenz (huggingface.co), die die einhaltung geltender gesetze und ethischer standards verlangt. verboten sind beispielsweise diskriminierende, gewaltverherrlichende oder anderweitig illegale inhalte. bei der nutzung von vortrainierten modellen oder ki-diensten sollten stets auch deren spezifische lizenzbedingungen geprüft werden.

- deepfakes & persönlichkeitsrechte: fotorealistische ki-bilder von real existierenden personen (sogenannte deepfakes) sind rechtlich heikel. in deutschland greifen hier das allgemeine persönlichkeitsrecht und der datenschutz (dsgvo) – ohne einwilligung darf niemandes abbild einfach verfremdet und verbreitet werden. der eu digital services act 2024 schreibt vor, dass manipulative ki-inhalte eindeutig gekennzeichnet werden müssen, wenn verwechslungsgefahr mit echtem material besteht.

- haftung: wer ki-bilder generiert und veröffentlicht, haftet für eventuelle rechtsverstöße genauso wie bei von hand geschaffenen werken. unternehmen und anwender*innen sollten sich der möglichen risiken (z.b. marken- oder persönlichkeitsverletzungen) bewusst sein und im zweifel rechtlichen rat einholen. der in vorbereitung befindliche eu ai act (artificialintelligenceact.eu) wird voraussichtlich weitere regeln für den ki-einsatz definieren. bis dahin gilt: vorsicht und verantwortungsbewusstsein bei der verwendung von generativen ki-tools.

ausprobieren: tipps zum einstieg

prompt-experimente: starten sie mit einfachen prompts und variieren Sie diese schrittweise (z.b. „porträt einer katze im van-gogh-stil“). Nutzen Sie auch negative prompts, um unerwünschte bildelemente auszuschließen und die ergebnisse zu verfeinern.

modelle testen: probieren sie verschiedene checkpoints aus – neben dem standardmodell (sd 1.5) etwa das hochauflösende sdxl (auch als stable diffusion 3.5 bekannt) oder spezialisierte modelle aus der community. auf hugging face (huggingface.co) finden sich offizielle modelle von stability ai; auf civitai tauscht die community zahllose fan-modelle, erweiterungen und sog. loras aus. jedes modell hat eigene stärken – hier lohnt es sich, zu experimentieren.

comfyui-manager nutzen: verwenden Sie das erwähnte comfyui manager-plugin, um neue modelle, nodes und erweiterungen bequem nachzuladen und aktuell zu halten. So bleibt Ihre comfyui-installation immer auf dem neuesten stand.

workflows laden: nutzen Sie beispiel-workflows aus der community als starthilfe. das erspart viel einstellungsarbeit und zeigt bewährte lösungswege.

seed & parameter anpassen: arbeiten Sie mit festen seeds, um bestimmte ergebnisse reproduzierbar zu machen. mehr sampling-schritte können oft mehr details hervorbringen – bedenken Sie aber, dass dadurch die rechenzeit steigt . testen Sie den einfluss verschiedener sampler (plms, euler, ddim etc.) auf das ergebnis. erfahrungsgemäß liefern mittlere parameterwerte oft schon gute resultate; extreme werte führen nicht zwangsläufig zu besseren bildern.

ergebnisse sichern & teilen: speichern Sie gelungene bilder ab und nutzen Sie foren oder soziale medien, um feedback einzuholen. In der reddit-community (etwa im r/stablediffusion) oder auf speziellen discord-servern werden täglich hunderte ki-bilder geteilt – dort können Sie von tipps erfahrener anwender*innen profitieren und Ihre werke präsentieren.

wichtige deutschsprachige ressourcen sind außerdem blogs wie ki im alltag sowie tech-magazine wie heise online oder golem, die verständliche einsteigertexte und aktuelle nachrichten zum thema bieten.

fazit: stable diffusion und comfyui bieten technikaffinen kreativen ein mächtiges, zugängliches werkzeug, um bilder in nie dagewesener geschwindigkeit zu generieren. mit etwas übung lassen sich eigene ideen visualisieren, arbeitsprozesse effizienter gestalten und künstlerische projekte bereichern – die einzigen grenzen setzen fantasie, rechtliche vorgaben und lizenzbestimmungen.